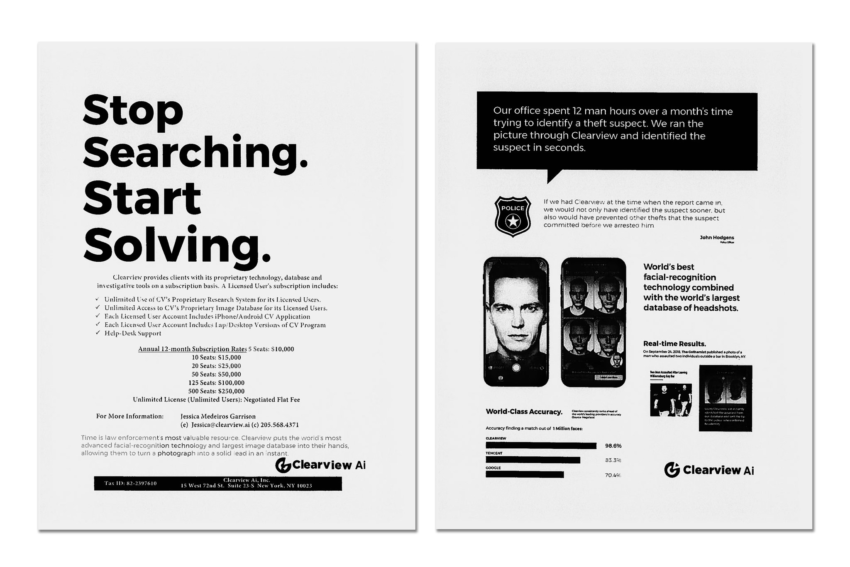

Un groupe d’ONG, a annoncé avoir saisi les autorités de protection de données de 5 pays Européens (Royaume-Uni, Italie, France, Grèce, Autriche) ce jeudi contre la start-up américaine Clearview AI (précédents articles), qui a constitué une immense base de données de visages (Plus de 3 milliards d’images en 2020) sur base de photos téléchargées automatiquement depuis les réseaux sociaux, des blogs personnels, des sites d’entreprise, etc. Clearview agit hors de tout cadre légal mais met pourtant à disposition des services de police et des institutions financières un service qui leur permet de rechercher des correspondances dans cette immense base de données.

Clearview avait suspendu il y a quelques mois son service au Canada, alors que l’autorité locale de protection des données l’accusait d’exercer une surveillance de masse illégale.

Dossier(s): Sécurité IT Tags: Autriche, France, Grande-Bretagne, Grèce, Internet, Italie, Technique de répression

Campagne à propos des photos dans les manifestations

Campagne à propos des photos dans les manifestations Campagnes de soutien médical aux combattant·es du Rojava

Campagnes de soutien médical aux combattant·es du Rojava